Si bien la IA permite a los profesionales de seguridad defenderse de ataques cada vez más sofisticados, también ofrece a los ciberdelincuentes nuevas maneras de potenciar sus actividades maliciosas. Esta doble función de la IA la convierte en un componente crucial de la ciberseguridad moderna: un arma de doble filo que puede proteger y dañar a la vez.

Por Roberto Rodríguez y Clarissa Grimaldo

Al ser una herramienta que a diario tiene actualizaciones que la potencializan, la Inteligencia Artificial (IA) ha tomado gran relevancia en los últimos años al recibir millones de datos en información que le ayudan a funcionar y mantenerse vigente, ayudando a crear nuevos artículos escritos, imágenes e incluso vídeos que pueden ayudar o perjudicar a las personas.

En entrevista para Hora Cero, el experto en Inteligencia Artificial Raúl Olivo Ibarra, mencionó que los sistemas o aplicaciones impulsados por la inteligencia artificial, constantemente están en desarrollo lo que les permite avanzar rápidamente en su aprendizaje, recopilando millones de datos en información que les brindan todos los usuarios alrededor del mundo y utilizan estas plataformas cotidianamente.

¿COMO APRENDE LA IA?

Raúl Olivo, dejó saber que la IA se entrena mediante aprendizajes supervisados, no supervisados y por refuerzo, aprendiendo con datos etiquetados y no etiquetados para descubrir patrones y estructuras, además de aprender a tomar decisiones mediante recompensas o penalizaciones.

Al existir demasiadas personas usándola cotidianamente, la Inteligencia Artificial puede fácilmente recopilar una gran cantidad de información para almacenarla y usarla cuando algún otro usuario necesite datos similares, provocando que su distribución sea cada vez más rápida.

“Si tú le muestras por ejemplo mil imágenes de un oso panda, entonces la siguiente imagen que le muestres del animal, la inteligencia artificial va a saber interpretar que es un oso panda, tras todo ese entrenamiento recibido con millones de datos, la IA también podrá crear otras imágenes basándose en la información que ha recibido”, mencionó.

USADA PARA DESPRESTIGIO

Si bien esta herramienta puede ser utilizada para apoyarse en la búsqueda de información o con otros fines científicos o educativos, la Inteligencia Artificial últimamente ha sido utilizada para organizar campañas en contra de actores políticos y otras figuras públicas a modo de desprestigiarlos y que su imagen vaya en decadencia, aunque Olivo Ibarra aseguró que nadie está exento de ser víctima por los distintos ataques que se puedan generar con la IA.

“La IA también puede ser utilizada para desprestigiar a las personas y no solamente políticos y famosos, sino también a personas comunes que son afectados con imágenes o videos manipulados por terceras personas”, subrayó.

Agregó que lamentablemente esto sucede de manera constante, ya que existen personas que se encargan de entrenar algún modelo de inteligencia artificial, proporcionándole imágenes de aquella persona que buscamos imitar con la IA y lo va a realizar sin problemas.

ASÍ SE TRABAJA CON LA IA EN TAMAULIPAS

En octubre de 2024, se registró en Reynosa el primer caso en Tamaulipas relacionado con el uso de Inteligencia Artificial para generar imágenes íntimas falsas con el rostro de una persona real. El objetivo fue extorsionar a la víctima con la amenaza de hacer públicas dichas imágenes a menos que entregara dinero a cambio. Aunque la persona afectada no participó en la creación de estas imágenes, su “rostro” (generado con IA) fue utilizado sin consentimiento.

De acuerdo con Javier Galindo Hernández, encargado de la Guardia Estatal Cibernética en Tamaulipas, este caso fue tratado como un delito de extorsión.

“Siempre les decimos que lo recomendable es reunir toda la información, como lo son los mensajes con amenazas y las imágenes editadas, para poder levantar una denuncia formal ante la fiscalía”, indicó.

El incidente pone en evidencia los nuevos desafíos que enfrentan las autoridades ante el uso indebido de las prácticas tecnológicas emergentes. Galindo advirtió que si bien este es el único caso registrado formalmente en el Estado hasta ahora, en otros lugares del país ya se han detectado patrones similares, entre ellos, la clonación de voces mediante IA para suplantar la identidad de personas y solicitar dinero a sus familiares.

Además de las imágenes falsas, las campañas de desinformación, el fraude y el robo de identidad son otras preocupaciones crecientes.

La facilidad para acceder a herramientas de IA y la exposición pública de datos personales (como fotografías en redes sociales) aumentan el riesgo.

“Nosotros recomendamos mantener en privado los perfiles sociales y evitar compartir audios o imágenes con personas desconocidas, ya que pueden ser utilizados para manipular o engañar a terceros”, agregó.

Ante esta situación, la dependencia ha reforzado su estrategia manteniéndose en constante actualización sobre las plataformas de IA más utilizadas (como ChatGPT, Meta AI, Gemini o Grok), para entender su funcionamiento y alertar sobre posibles usos indebidos.

El principal reto, reconocen, es mantener informada a toda la ciudadanía sobre los riesgos que se presentan ante el mal uso de la Inteligencia Artificial.

“Aunque parezca sencillo configurar la privacidad de nuestras cuentas, muchas personas aún no lo hacen, y esa es una puerta abierta para los ciber delincuentes”, resaltó el funcionario.

El encargado de la Policía Cibernética en Tamaulipas advirtió sobre otra práctica que se ha vuelto viral en redes sociales, que consiste en el uso de Inteligencia Artificial para convertir imágenes personales en caricaturas. Aunque puede parecer inofensivo, esta actividad puede representar un riesgo, especialmente por el nivel de difusión que puedan alcanzar dichas imágenes.

“No está mal transformar nuestras fotografías en versiones animadas o con una temática específica, pero debemos tener cuidado con quién compartimos ese contenido. Muchas veces queremos presumir y lo hacemos público, lo que abre la posibilidad de que un usuario malintencionado tome las imágenes originales y las modifique con fines indebidos”, señaló.

Javier Galindo destacó que uno de los principales desafíos que enfrenta la dependencia ante el creciente uso de la Inteligencia Artificial, es informar a la ciudadanía sobre las medidas de prevención necesarias para proteger su información personal.

“Aunque configurar la privacidad parece algo sencillo, muchas personas aún no tienen acceso a información preventiva. Por eso, diariamente realizamos campañas de concientización a través de nuestras redes sociales, ya que son una vía efectiva para llegar a diversos públicos”, añadió.

LA ‘DEEP FAKE’

Existen modelos de IA que les permite a los usuarios crear contenidos falsos de personas reales que logran replicar sus gestos, voz y expresiones faciales a la perfección, mediante vídeos, imágenes o audios, lo cual es conocido como “Deep Fake”.

Ante esto, Raúl Olivo detalló que las replicas que brinda la IA con softwares como el “Deep Fake” son demasiado fieles a la realidad y suelen crear controversia entre las personas que llegan a ver estos contenidos ya que los confunden y no logran distinguir si la imagen o vídeo es real o falso.

“Son riesgos enormes los que se corren con la creación de contenidos, porque pueden ser en ocasiones para algo divertido, como crear una imagen comiendo con un artista o cosas similares y no pasa a mayores, sin embargo, si es utilizado para otros fines puede resultar muy difícil de manejar una vez que se distribuya”, dijo Olivo Ibarra.

EL MAL USO DE LA INTELIGENCIA ARTIFICIAL

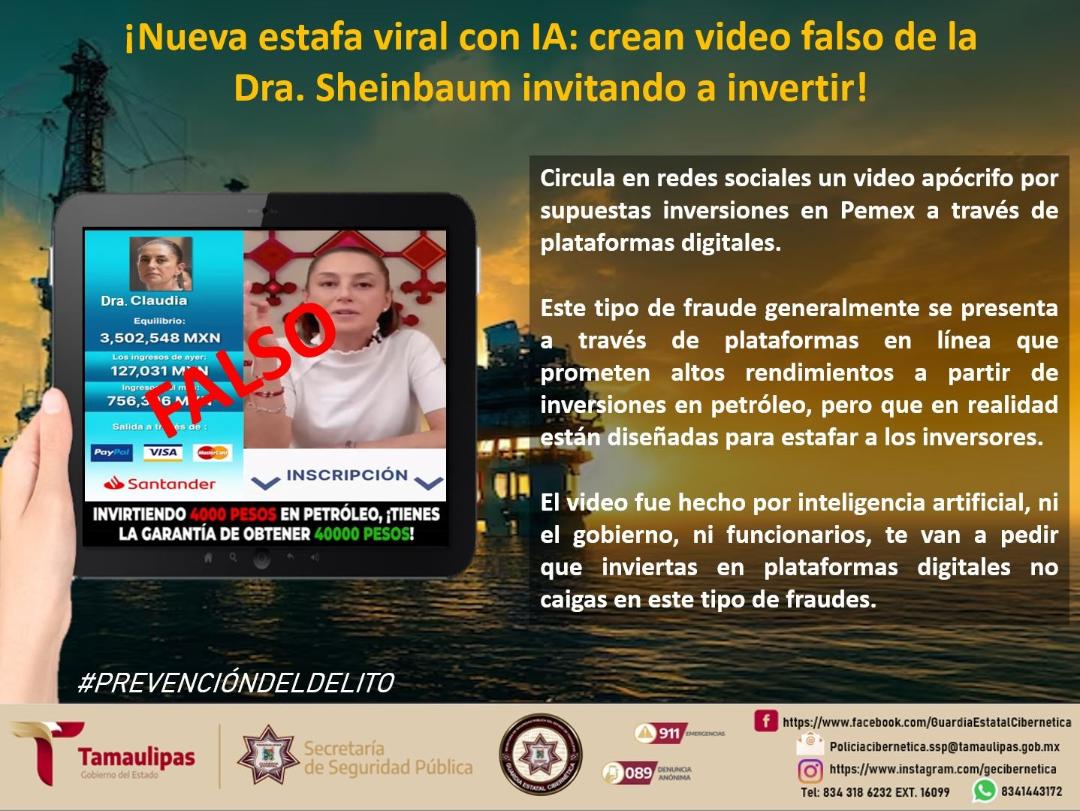

Un ejemplo del uso de la Inteligencia Artificial para cometer estafas ocurrió en el pasado mes de febrero, cuando comenzó a circular un video falso de la presidenta Claudia Sheinbaum. En el material, supuestamente, se le ve invitando a inversionistas a apoyar a Pemex a través de plataformas digitales.

Este tipo de fraudes suele difundirse principalmente en redes sociales, donde se prometieron altos rendimientos a partir de inversiones en petróleo. Sin embargo, en realidad están diseñados para engañar a los usuarios y defraudar a quienes invierten.

En el caso del video, éste fue generado con Inteligencia Artificial e incluía fragmentos en los que se imitaba incluso la voz de la mandataria, quien supuestamente promovía sitios de inversión que prometían grandes ganancias con una inversión mínima.

Ante esta situación, la propia presidenta tuvo que salir a desmentir públicamente el contenido, aclarando que se trataba de una estafa y que ella no estaba promoviendo ningún tipo de inversión.

Otro caso que sí logró concretarse como estafa fue el de una mujer francesa, víctima de un engaño en enero de este año. Los estafadores utilizaron inteligencia artificial para suplantar la identidad del reconocido actor Brad Pitt.

Anne, una mujer de 53 años, creyó haber mantenido una relación virtual con el actor durante un año y medio. Los estafadores la convencieron de que Pitt había intentado enviarle regalos de lujo, pero que no pudo cubrir los costos de aduana debido a que sus cuentas bancarias estaban congeladas por su proceso de divorcio con Angelina Jolie. Esto llevó a la mujer a realizar una transferencia de 850 euros (equivalente a 18 mil 454 pesos mexicanos).

La estafa escaló cuando los estafadores argumentaron que el actor necesitaba dinero en efectivo para pagar un tratamiento contra el cáncer de riñón, y enviaron fotografías falsas, generadas con inteligencia artificial, en las que supuestamente aparecía Brad Pitt hospitalizado.

La mujer se dio cuenta del engaño cuando la nueva relación sentimental del actor fue publicada en revistas y medios internacionales. Fue entonces cuando acudió a la policía para denunciar los hechos y canalizar su caso.